La necesidad de crawling datos web ha aumentado en los últimos años. Los datos crawled se pueden usar para evaluación o predicción en diferentes campos. Aquí, me gustaría hablar sobre 3 métodos que podemos adoptar para scrape datos desde un sitio web.

1. Utilice Website APIs

Muchos sitios web de redes sociales grandes, como Facebook, Twitter, Instagram, StackOverflow, proporcionan API para que los usuarios accedan a sus datos. A veces, puede elegir las API oficiales para obtener datos estructurados. Como se muestra a continuación en la Facebook Graph API, debe elegir los campos donde realiza la consulta, luego ordenar los datos, realizar la búsqueda de URL, realizar solicitudes, etc. Para obtener más información, puede consultar https://developers.facebook.com/docs/graph-api/using-graph-api.

2. Construye tu propio crawler

Sin embargo, no todos los sitios web proporcionan API a los usuarios. Ciertos sitios web se niegan a proporcionar API públicas debido a límites técnicos u otras razones. Alguien puede proponer fuentes RSS, pero debido a que ponen un límite a su uso, no sugeriré ni haré más comentarios al respecto. En este caso, lo que quiero discutir es que podemos construir un crawler por nuestra cuenta para hacer frente a esta situación.

¿Cómo funciona un crawler? Un crawler, dicho de otra manera, es un método para generar una lista de URL que puede alimentar a través de su extractor. Los crawlers se pueden definir como herramientas para encontrar las URL. Primero le da al crawler una página web para que comience, y ellos seguirán todos estos enlaces en esa página. Entonces este proceso continuará en un bucle.

Entonces, podemos proceder a construir nuestro propio crawler. Se sabe que Python es un lenguaje de programación de código abierto, y puede encontrar muchas bibliotecas funcionales útiles. Aquí, sugiero BeautifulSoup (Python Library) porque es más fácil de trabajar y posee muchos caracteres intuitivos. Más exactamente, utilizaré dos módulos de Python para crawl los datos.

BeautifulSoup no obtenar la página web para nosotros. Por eso uso urllib2 para combinar con la biblioteca BeautifulSoup. Luego, debemos lidiar con las etiquetas HTML para encontrar todos los enlaces dentro de las etiquetas de la página y la tabla derecha. Después de eso, repita cada tr (td) y luego asigne cada elemento de tr (td) a una variable y añádalo a una lista. Primero veamos la estructura HTML de la tabla (no voy a extraer información para la título de la tabla

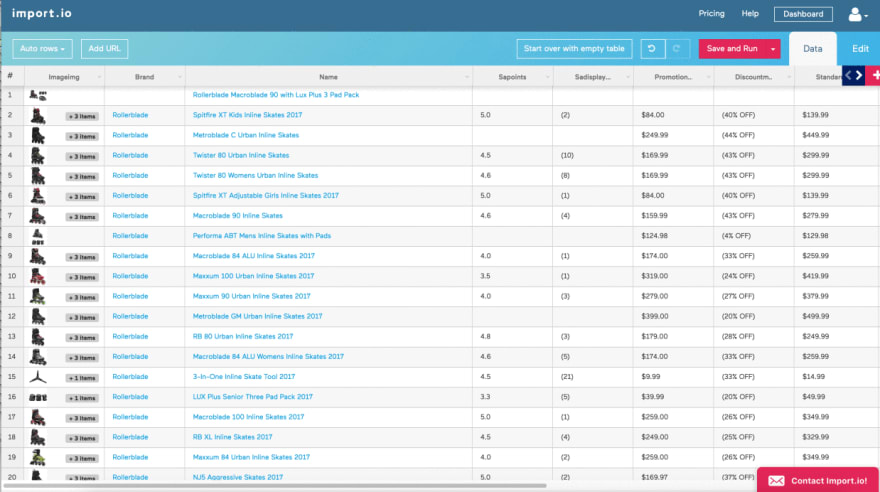

Al adoptar este enfoque, su crawler se personaliza. Puede lidiar con ciertas dificultades encontradas en la extracción de API. Puede usar el proxy para evitar que algunos sitios web lo bloqueen, etc. Todo el proceso está bajo su control. Este método debería tener sentido para las personas con habilidades de codificación. El marco de datos que crawled debe ser como la figura a continuación.

3. Aproveche las herramientas de ready-to-use crawler

Sin embargo, crawl un sitio web por su cuenta mediante la programación puede llevar mucho tiempo. Para las personas sin habilidades de codificación, esta sería una tarea difícil. Por lo tanto, me gustaría presentar algunas Crawler Tools.

Octoparse

Octoparse es un poderoso web data crawler. Es realmente fácil para los usuarios comprender esta herramienta con su interfaz de usuario simple y amigable. Para usarlo, debe descargar esta aplicación en su escritorio local.

Como se muestra en la figura a continuación, puede hacer clic y arrastrar los bloques en el panel Workflow Designer para personalizar su propia tarea. Octoparse ofrece dos ediciones de planes de suscripción de crawling service: la Edición Gratuita y la Edición de Pago. Ambos pueden satisfacer las necesidades básicas de scraping o crawling de los usuarios. Con la edición gratuita, puede ejecutar sus tareas en el lado local.

Si cambia su edición gratuita a una Edición de Pago, puede usar el Cloud-based servicecargando sus tareas en la Plataforma de la nube. De 6 a 14 servidores en la nube ejecutarán sus tareas simultáneamente con una mayor velocidad y crawl a mayor escala. Además, puede automatizar su extracción de datos sin dejar rastro utilizando la función de proxy anónimo de Octoparse que podría rotar toneladas de IP, lo que evitará que ciertos sitios web lo bloqueen. Aquí hay un video que presenta Octoparse Cloud Extraction.

Octoparse también proporciona API para conectar su sistema a sus datos scraped en tiempo real. Puede importar los datos de Octoparse en su propia base de datos o usar la API para solicitar acceso a los datos de su cuenta. Después de finalizar la configuración de la tarea, puede exportar datos a varios formatos, como CSV, Excel, HTML, TXT y database (MySQL, SQL Server y Oracle).

Import.io también se conoce como un web crawler que cubre todos los diferentes niveles de necesidades de crawling. Ofrece una herramienta mágica que puede convertir un sitio en una formar sin ninguna sesión de entrenamiento. Sugiere a los usuarios descargar su aplicación de escritorio si es necesario crawl sitios web más complicados. Una vez que haya creado su API, ofrecen una serie de opciones de integración simples, como Google Sheets, Plot.ly, Excel, así como solicitudes GET y POST. Cuando considera que todo esto viene con una etiqueta de precio de por vida y un equipo de soporte increíble, import.io es un primer elección claro para aquellos que buscan datos estructurados. También ofrecen una opción paga de nivel empresarial para empresas que buscan una extracción de datos más compleja o a gran escala.

Mozenda

Mozenda es otro extractor de datos web fácil de usar. Tiene una interfaz de usuario de apuntar y hacer clic para usuarios sin ninguna habilidad de codificación para usar. Mozenda también elimina la molestia de automatizar y publicar datos extraídos. Dígale a Mozenda qué datos desea una vez, y luego obténgalos con la frecuencia que los necesite. Además, permite una programación avanzada utilizando REST API que el usuario puede conectar directamente con la cuenta Mozenda. Proporciona el servicio basado en la nube y la rotación de IP también.

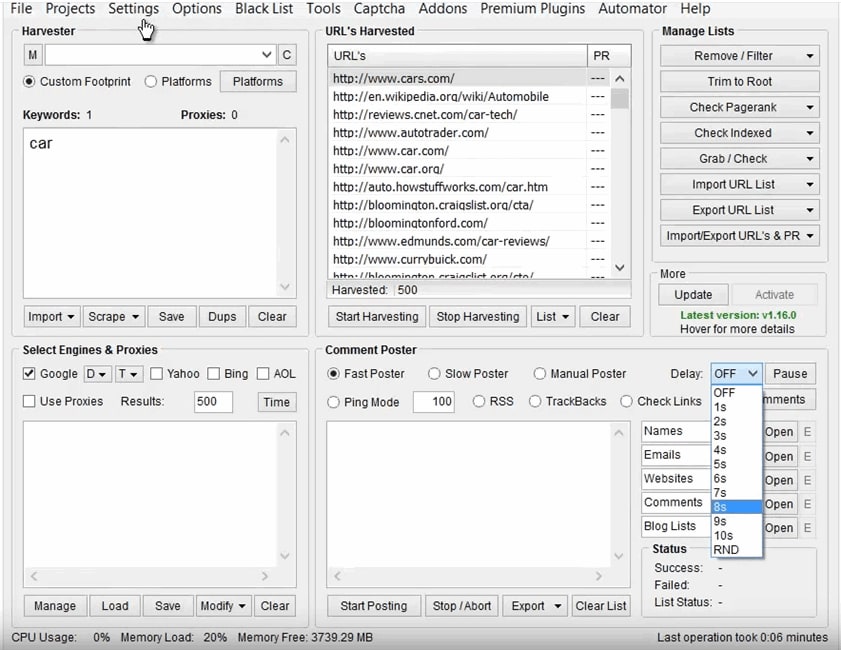

ScrapeBox

SEO expertos, los vendedores en línea e incluso los spammers deberían estar muy familiarizados con ScrapeBox con su interfaz de usuario muy fácil de usar. Los usuarios pueden recolectar fácilmente datos de un sitio web para recibir correos electrónicos, verificar el rango de la página, verificar los servidores proxy y el envío de RSS. Mediante el uso de miles de servidores proxy rotativos, podrá escabullirse de las palabras clave del sitio de la competencia, investigar en sitios .gov, recopilar datos y comentar sin ser bloqueado o detectado.

Si la gente solo quiere scrape datos de una manera simple, le sugiero que elija el complemento Google Web Scraper. Es un web scraper basado en navegador que funciona como Outwit Hub de Firefox. Puede descargarlo como una extensión e instalarlo en su navegador. Debe resaltar los campos de datos que desea scrape, hacer clic con el botón derecho y elegir "Scrape similar ...". Todo lo que sea similar a lo que destacó se representará en una tabla lista para exportar, compatible con Google Docs. La última versión todavía tenía algunos errores en las hojas de cálculo. Aunque es fácil de manejar, no puede scrape imágenes y crawl datos en gran cantidad.

Top comments (0)